En esta entrada voy a mostrar una serie de conceptos (unos cuantos) relacionados con un Datacenter o Centro de Procesamiento de Datos, que es necesario conocer y repasar.

Por otro lado, podemos ampliar este post con vuestros comentarios para mejorar este miniglosario y añadir nuevos términos relacionados.

Comencemos, que esta entrada es larga …

Versión 1.1.4, actualizado a 24 – 01 – 2014

![]() Especificaciones más relevantes de las normas para CPD

Especificaciones más relevantes de las normas para CPD

En un CPD, El sistema de cableado genérico tiene similar importancia que los otros sistemas del recinto. Las interrupciones en el servicio por un diseño incorrecto, uso de componentes inadecuados, instalaciones mal realizadas, mala administración y soporte ineficiente ponen riesgo la efectividad de la organización o la continuidad de su negocio. Para minimizar estos riesgos, es esencial el desarrollo y adopción de normas especializadas en centros de datos.

– Norma internacional ISO/IEC 24764

– Norma norteamericana ANSI/TIA-942-A

– EN-50173-5 Information technology – Generic cabling systems – Part 5: Data centres

– BICSI-002. Data Center Design and Implementation Best Practices

– ICREA Std-131-2011 Norma Internacional para la Construcción de Centros de Procesamiento de Datos

– EUROPEAN COMMISSION: Code of Conduct on Data Centres Energy Efficiency

– ASHRAE. Thermal Guidelines for Data Processing Environments

Información relacionada en formato: PDF

La palabra backbone se refiere a las principales conexiones troncales de Internet. Está compuesta de un gran número de routers comerciales, gubernamentales, universitarios y otros de gran capacidad interconectados que llevan los datos a través de países, continentes y océanos del mundo mediante cables de fibra óptica.

Parte de la extrema resiliencia( en sistemas tecnológicos, la resiliencia es la capacidad de un sistema de soportar y recuperarse ante desastres y perturbaciones) de Internet se debe a su diseño estructural, ubicando las funciones de estado y control en los propios elementos de la red y relegando la mayor parte del procesamiento a los extremos finales. De esta forma se asegura la integridad, fiabilidad y autenticidad de los datos.

El término backbone también se refiere al cableado troncal o subsistema vertical en una instalación de red de área local que sigue la normativa de cableado estructurado.

La «columna vertebral» de Internet consiste en muchas redes diferentes. Normalmente, el término se usa para describir grandes redes que se interconectan entre ellas y pueden tener ISPs individuales como clientes. Por ejemplo, un ISP local puede proporcionar servicio para una única ciudad, y conectar a un proveedor regional que tiene varios ISPs locales como clientes. Este proveedor regional conecta a una de las redes del backbone, que proporciona conexiones a escala nacional o mundial.

Estos proveedores backbone normalmente proporcionan instalaciones de conexión en muchas ciudades para sus clientes, y ellos mismos conectan con otros proveedores backbone en IXPs (Internet Exchange Point) como el CATNIX de Barcelona, el ESPANIX de Madrid o el GALNIX de Santiago de Compostela. El más grande de estos IXP en términos de tasa de transferencia y rutas accesibles es el ChtIX en Roubaix Valley, Francia.

Points of Presence

Un punto de presencia es un punto de acceso a Internet. Se trata de un lugar físico que alberga los servidores , routers , ATM switches y agregadores de llamadas digitales / analógicas. Puede ser parte de las instalaciones de un proveedor de telecomunicaciones que el proveedor de servicios de Internet (ISP) o alquila una ubicación independiente del proveedor de telecomunicaciones. Los ISPs suelen tener múltiples puntos de presencia, a veces cientos. Los PoPs también se encuentran en los puntos de intercambio de Internet y centros de colocación.

Computer Room Air conditioning (CRAC)

Es un dispositivo de control que mantiene la temperatura, la distribución del aire y la humedad en una habitación de la red o centro de datos . Las unidades CRAC están reemplazando unidades de aire acondicionado que se utilizaron en el pasado para enfriar los centros de datos. De acuerdo con las tendencias del mercado industrial, los mainframes y bastidores de servidores se calientan excesivamente, por lo que el control del clima es una parte importante de la infraestructura del centro de datos.

Hay una variedad de formas de situación de las unidades CRAC. Una configuración CRAC que ha tenido éxito es el proceso de enfriamiento de aire y hacer que se disperse a través de un piso elevado. El aire sube a través de las secciones perforadas, formando pasillos fríos.

Las soluciones DCIM (siglas de Data Center Infrastructure Management) surgieron en un principio como sistemas de monitorización destinados a medir el consumo energético en los centros de datos, con objeto de reducir en lo posible la huella de carbono.

Los mercados en los que el sector de los centros de datos está más evolucionado, como Estados Unidos y algunos países europeos, se dieron cuenta primero de la necesidad de tener una precisión mayor, y en una mayor cantidad, en el uso de todos los subsistemas, debido no solo a la imperiosa necesidad de reducir su impacto medioambiental y su factura eléctrica, sino al cambio radical del uso de los componentes que trajo consigo la alta densidad.

DCIM es, en todo caso, la forma más inteligente de gestionar un centro de datos. Permite integrar la gestión de las instalaciones y de los elementos TI bajo un mismo paraguas, con herramientas capaces de interpretar las mediciones realizadas en cada uno de los sistemas existentes en el data center.

Las herramientas DCIM más evolucionadas, en efecto, recogen e interpretan los diferentes datos de energía, calor, etc., y los muestran en un único punto de control unificado. También permiten realizar simulaciones para que los gestores del centro de datos puedan prepararse para los posibles problemas e incluso anticiparse a ellos.

Las soluciones BMS son sistemas de control informático de edificios. Permiten monitorizar y controlar elementos mecánicos y eléctricos, desde la refrigeración y los sistemas antiincendios hasta la seguridad, la iluminación o la energía. A su manera, fueron precursores del DCIM, aunque desde un punto de vista más amplio, menos segmentado.

![]() Certificacion Tier de Uptime Institute.

Certificacion Tier de Uptime Institute.

Si estamos buscando un servicio de alojamiento de servidores, colocación, etc. veremos que los diferentes proveedores ofrecen información de lo más variada sobre sus características y datos interesantes como niveles de redundancia, tamaño del centro de datos, tiempos de respuesta y demás.

Existe un estándar llamado ANSI/TIA-942 Telecommunications Infrastructure Standard for Data Centers, creado por miembros de la industria, consultores y usuarios, que intenta estandarizar el proceso de diseño de los centros de datos. El estándar está orientado a ingenieros y expertos en la materia. Sin embargo, hay una parte del estándar que vale la pena conocer cuando contratamos servicios de alojamiento en un centro de datos: Los Tiers.

Este sistema de clasificación fue inventado por el Uptime Institute para clasificar la fiabilidad (y también para hacer negocio certificando los centros de datos).

El concepto de Tier nos indica el nivel de fiabilidad de un centro de datos asociados a 4 niveles de disponibilidad definidos. A mayor número en el Tier, mayor disponibilidad, y por lo tanto mayores costes asociados en su construcción y más tiempo para hacerlo.

A día de hoy se han definido 4 Tier diferentes, y ordenados de menor a mayor son:

Tier 1:

- Centro de datos Básico: Disponibilidad del 99.671%.

- El servicio puede interrumpirse por actividades planeadas o no planeadas.

- No hay componentes redundantes en la distribución eléctrica y de refrigeración.

- Puede o no puede tener suelos elevados, generadores auxiliares o UPS.

- Tiempo medio de implementación, 3 meses.

- La infraestructura del datacenter deberá estar fuera de servicio al menos una vez al año por razones de mantenimiento y/o reparaciones.

Tier 2:

- Centro de datos Redundante: Disponibilidad del 99.741%.

- Menos susceptible a interrupciones por actividades planeadas o no planeadas.

- Componentes redundantes (N+1)

- Tiene suelos elevados, generadores auxiliares o UPS.

- Conectados a una única línea de distribución eléctrica y de refrigeración.

- De 3 a 6 meses para implementar.

- El mantenimiento de esta línea de distribución o de otras partes de la infraestructura requiere una interrupción de las servicio.

Tier 3:

- Centro de datos Concurrentemente Mantenibles: Disponibilidad del 99.982%.

- Permite planificar actividades de mantenimiento sin afectar al servicio de computación, pero eventos no planeados pueden causar paradas no planificadas.

- Componentes redundantes (N+1)

- Conectados múltiples líneas de distribución eléctrica y de refrigeración, pero únicamente con una activa.

- De 15 a 20 meses para implementar.

- Hay suficiente capacidad y distribución para poder llevar a cabo tareas de mantenimiento en una línea mientras se da servicio por otras.

Tier 4: Centro de datos Tolerante a fallos: Disponibilidad del 99.995%.

- Permite planificar actividades de mantenimiento sin afectar al servicio de computación críticos, y es capaz de soportar por lo menos un evento no planificado del tipo ‘peor escenario’ sin impacto crítico en la carga.

- Conectados múltiples líneas de distribución eléctrica y de refrigeración con múltiples componentes redundantes (2 (N+1) significa 2 UPS con redundancia N+1).

- De 15 a 20 meses para implementar.

Por ejemplo, si en la publicidad de un proveedor presume de ser Tier 3, lo que nos está diciendo es que su infraestructura no fallará más de 1.6 horas al año, que no hay interrupciones por mantenimientos planificados y que puede haber eventos inesperados que causen interrupciones del servicio. Hay que recalcar que se refiere a la infraestructura del centro de datos, y que otros aspectos como la disponibilidad de los equipos que van dentro del datacenter se gestionan aparte.

El housing una modalidad de alojamiento web destinado principalmente a grandes empresas y a empresas de servicios web.

Consiste básicamente en vender o alquilar un espacio físico de un centro de datos para que el cliente coloque ahí su propio ordenador. La empresa le da la corriente y la conexión a Internet, pero el servidor lo elige completamente el cliente, incluso el hardware.

El término «housing» proviene de los países hispanohablantes y otros como Francia. Sin embargo en países de habla inglesa utilizan colocation , colocation center o también Co-Location

Internet Assigned Numbers Authority (cuyo acrónimo es IANA) es la entidad que supervisa la asignación global de direcciones IP, sistemas autónomos (lo veremos mas adelante), servidores raíz de nombres de dominio DNS y otros recursos relativos a los protocolos de Internet. Actualmente es un departamento operado por ICANN.

En sus inicios, IANA fue administrada principalmente por Jon Postel en el Instituto de Ciencias de la Información (ISI) de la Universidad del Sur de California (USC), en virtud de un contrato de USC/ISI con el Departamento de Defensa estadounidense, hasta que se creó la ICANN para asumir la responsabilidad bajo un contrato del Departamento de Comercio.

La Corporación de Internet para la Asignación de Nombres y Números. ICANN es una organización que opera a nivel multinacional/internacional) y es la responsable de asignar las direcciones del protocolo IP, de los identificadores de protocolo, de las funciones de gestión del sistema de dominio y de la administración del sistema de servidores raíz.

En un principio y actualmente, estos servicios los realizaba IANA (Internet Assigned Numbers Authority) y otras entidades del gobierno estadounidense. ICANN se dedica a preservar la estabilidad de Internet por medio de procesos basados en el consenso. ICANN coordina la administración de los elementos técnicos del DNS para garantizar la resolución unívoca de los nombres, para que los usuarios puedan encontrar todas las direcciones sin ser repetidas.

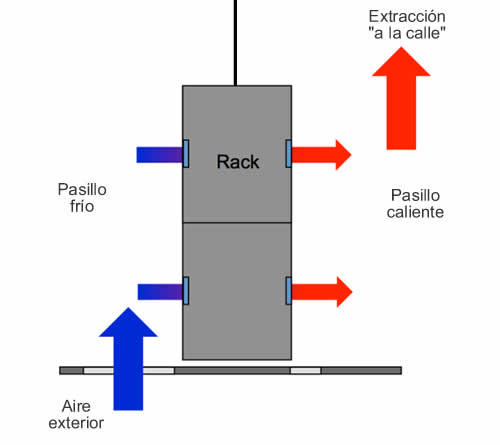

![]() Free cooling, y ahorro energético por frio.

Free cooling, y ahorro energético por frio.

Los equipos instalados en estos centros generan un cantidad de calor bastante importante, el cuál es necesario evitar para conseguir un correcto funcionamiento de los sistemas. Una temperatura de entrada de aire de 25ºC suele ser más que suficiente para mantener el equipo en buenas condiciones de funcionamiento. Pero esto no es todo. En función de la época del año, por encima de la marca de los 25ºC existen solamente 150h (al menos en mi zona) horas al año, lo que hace que la mayor parte del tiempo podamos utilizar el aire exterior para refrigerar nuestros equipos sin necesidad de sistemas de climatización basados en ciclos de compresión.

Para llevar a cabo un sistema de enfriamiento gratuito en un data center, uno de los pasos más importantes es crear una barrera física entre el pasillo frío(zona de toma de aire de los equipos) y el pasillo caliente (zona de descarga de aire caliente de los equipos).

Una vez delimitadas las dos zonas, se impulsará aire exterior en el pasillo frío y se extraerá el aire del pasillo caliente enviándolo “a la calle”. De esta forma conseguimos que los equipos tomen solamente aire de la zona más fresca (pasillo frío) y evitaremos que el aire caliente expulsado se vuelva a tomar por la parte frontal del servidor de datos.

Obviamente todo esto es mucho más complejo, se necesitan sistemas de filtrado avanzados, un control electrónico preciso de condiciones climáticas, un sistema de control de temperatura mínima de impulsión y otra serie de elementos en los que no vamos a entrar en este post.

¿DONDE ESTÁ EL AHORRO DE ENERGÍA?

Sencillo, si tengo un equipo de refrigeración por compresión, éste tomará el aire caliente expulsado por el servidor y lo refrigerará para que el CPD lo pueda volver a tomar, todo ello con un alto consumo energético.

En el caso del sistema free-cooling, el coste energético del aire fresco solamente sería el asociado al consumo de los ventiladores de aporte y extracción, mucho más bajo que el de un compresor de refrigerante, de ahí el ahorro.

¿EVITARÉ ASÍ INSTALAR UN SISTEMA DE REFRIGERACIÓN POR GAS REFRIGERANTE?

No, ya que las 150 horas del ejemplo donde estamos a más de 25ºC, el sistema free-cooling no sería efectivo y necesitas refrigerar el ambiente de alguna forma. Este tipo de sistemas sirven exclusivamente para ahorro energético y no deben utilizarse como sistemas de seguridad.

![]() Cloud computing y Servidor en la nube

Cloud computing y Servidor en la nube

En este tipo de computación todo lo que puede ofrecer un sistema informático se ofrece como servicio, de modo que los usuarios puedan acceder a los servicios disponibles «en la nube de Internet» sin conocimientos (o, al menos sin ser expertos) en la gestión de los recursos que usan. Según el IEEE Computer Society, es un paradigma en el que la información se almacena de manera permanente en servidores de Internet y se envía a cachés temporales de cliente, lo que incluye equipos de escritorio, centros de ocio, portátiles, etc.

La computación en la nube son servidores desde Internet encargados de atender las peticiones en cualquier momento. Se puede tener acceso a su información o servicio, mediante una conexión a internet desde cualquier dispositivo móvil o fijo ubicado en cualquier lugar. Sirven a sus usuarios desde varios proveedores de alojamiento repartidos frecuentemente por todo el mundo. Esta medida reduce los costes, garantiza un mejor tiempo de actividad y que los sitios web sean invulnerables a los hackers, a los gobiernos locales y a sus redadas policiales.

«Cloud computing» es un nuevo modelo de prestación de servicios de negocio y tecnología, que permite incluso al usuario acceder a un catálogo de servicios estandarizados y responder con ellos a las necesidades de su negocio, de forma flexible y adaptativa, en caso de demandas no previsibles o de picos de trabajo, pagando únicamente por el consumo efectuado, o incluso gratuitamente en caso de proveedores que se financian mediante publicidad o de organizaciones sin ánimo de lucro.

El cambio que ofrece la computación desde la nube es que permite aumentar el número de servicios basados en la red. Esto genera beneficios tanto para los proveedores, que pueden ofrecer, de forma más rápida y eficiente, un mayor número de servicios, como para los usuarios que tienen la posibilidad de acceder a ellos, disfrutando de la ‘transparencia’ e inmediatez del sistema y de un modelo de pago por consumo. Así mismo, el consumidor ahorra los costes salariales o los costes en inversión económica (locales, material especializado, etc).

Computación en nube consigue aportar estas ventajas, apoyándose sobre una infraestructura tecnológica dinámica que se caracteriza, entre otros factores, por un alto grado de automatización, una rápida movilización de los recursos, una elevada capacidad de adaptación para atender a una demanda variable, así como virtualización avanzada y un precio flexible en función del consumo realizado, evitando además el uso fraudulento del software y la piratería.

La computación en nube es un concepto que incorpora el software como servicio, como en la Web 2.0 y otros conceptos recientes, también conocidos como tendencias tecnológicas, que tienen en común el que confían en Internet para satisfacer las necesidades de cómputo de los usuarios.

Servidor en la nube:

Es una tecnología innovadora que permite el crecimiento de su negocio de una forma sencilla y transparente. Mediante este servicio su plataforma no se encuentra en un solo servidor sino en varios servidores conectados entre si (nube). Esta tecnología permite la creación de Centros de Datos Virtuales que incrementan el desempeño, estabilidad y disminuyen notoriamente los gastos de infraestructura.

Beneficios

Posibilidad de contratar más recursos como procesador, memoria y almacenamiento en cualquier momento si necesidad de hacer cambios de hardware y sin traumatismos para sus aplicativos.

Alta disponibilidad, debido a que no es sólo un servidor el que presta su servicio, en el caso de que un servidor presente un problema técnico sus aplicativos continuarán trabajando sin ningún inconveniente.

Redundancia, su información es almacenada en varios servidores simultaneamente a diferencia de los servidores virtuales y dedicados.

El servidor en la nube es ofrecido por de empresas dedicadas a brindar hospedajes y dominios. Este tipo de servidores con precios económicos dependen de tu presupuesto y las características que necesites. Es decir, que los precios están definidos a partir de qué tipo de procesador necesitas, cuál sistema operativo, cuántas gigas de almacenamiento, que velocidad y cuánto espacio en el disco duro.

Te brindan CPU, RAM almacenamiento en cualquier combinación. Los servidores pueden ser escalables y adaptables, es decir que a través de consolas como Web o Api te permiten tener una mayor infraestructura.

El servidor en nube es la forma de usar los servicios informáticos como programas o aplicaciones fácilmente por el internet lo que te permite optimizar y administrar de la mejor manera tus herramientas web.

Se conoce como servidor virtual a una partición dentro de un servidor que habilita varias máquinas virtuales dentro de dicha máquina por medio de varias tecnologías.

Los servidores dedicados virtuales (SDV o VPS) usan una avanzada tecnología de virtualización, que le permite proveer acceso [root] y la capacidad de reiniciarlo cuando desee, «igual» que un servidor dedicado. Con la posibilidad de instalar sus propias aplicaciones y controlar completamente la configuración de su servidor, los VPS representan una alternativa económica y eficiente para aquellos que desean disfrutar los beneficios de un servidor dedicado pero aun no poseen el presupuesto para hacerlo. Por su puesto, el rendimiento no es tan eficaz como un decicado (con recursos similares).

Cada SDV tiene asignado un límite del uso de la CPU y la memoria RAM (entre otros) que es dedicado sólo el de dentro del servidor. Así, cada uno de los SDV funcionan independientemente dentro del mismo servidor físico; es decir que actúan como jaulas dentro de un mismo equipo. Por ejemplo, si uno de ellos está mal administrado y trabaja en forma sobrecargada, no afectará el funcionamiento del resto.

En cambio, en un hosting compartido (tanto reseller como individual) los recursos del servidor se comparten entre todas las cuentas de «hosting» que haya en él, y, si hay un problema de sobrecarga —quizás generado por el uso abusivo de un sólo dominio—, el rendimiento del «hosting» se verá sobrecargado en todo el equipo; es decir, en todas sus cuentas.

Se conoce como servidor virtual SPEC (Servidor élite en entorno Clúster) a una solución especialmente dirigida al sector profesional —y, en algún caso, al cliente final—, que permite gestionar virtualmente un servidor y optimizar recursos gracias a la utilización de una potente infraestructura redundada, clusterizada y con posibilidad de montar VPN. Permite configurar sistemas o aplicaciones, soportar cualquier tipo de servicio y determinar como desarrollarlo y definirlo.

Si necesitamos alojar múltiples sitios web, un Servidor Virtual Privado (VPS) es la opción más económica. Podemos alojar numerosos sitios web en un VPS sin los gastos derivados de tener que adquirir su propio servidor físico independiente.

Un servidor dedicado es un ordenador comprado o arrendado que se utiliza para prestar servicios dedicados, generalmente relacionados con el alojamiento web y otros servicios en red. A diferencia de lo que ocurre con el alojamiento compartido, en donde los recursos de la máquina son compartidos entre un número indeterminado de clientes, en el caso de los servidores dedicados generalmente es un solo cliente el que dispone de todos los recursos de la máquina para los fines por los cuales haya contratado el servicio.

Ventajas

El cliente puede disponer de todos los recursos de la máquina.

La configuración del servidor puede estar completamente adaptada a las necesidades particulares del cliente.

Existe un mayor control sobre las aplicaciones que corre el servidor web.

El mantenimiento y las actualizaciones de seguridad pueden ser realizadas con mayor facilidad y control.

Desventajas

La principal desventaja de un servidor dedicado es el costo del servicio, el cual es muy superior al del alojamiento compartido. Ésto debido principalmente al costo mensual de la máquina y la necesidad de contratar los servicios para la administración y configuración del servido

El alojamiento web (en inglés web hosting) es el servicio que provee a los usuarios de Internet un sistema para poder almacenar información, imágenes, vídeo, o cualquier contenido accesible vía web. Es una analogía de «hospedaje o alojamiento en hoteles o habitaciones» donde uno ocupa un lugar específico, en este caso la analogía alojamiento web o alojamiento de páginas web, se refiere al lugar que ocupa una página web, sitio web, sistema, correo electrónico, archivos etc. en internet o más específicamente en un servidor que por lo general hospeda varias aplicaciones o páginas web (recusos computacionales compartidos).

Las compañías que proporcionan espacio de un servidor a sus clientes se suelen denominar con el término en inglés web host. Existen hospedajes gratuitos y de pago.

El hospedaje web aunque no es necesariamente un servicio, se ha convertido en un lucrativo negocio para las compañías de internet alrededor del mundo.

Se puede definir como «un lugar para tu página web o correos electrónicos«, aunque esta definición simplifica de manera conceptual el hecho de que el alojamiento web es en realidad espacio en Internet para prácticamente cualquier tipo de información, sea archivos, sistemas, correos electrónicos, videos etc.

![]() Sistema de detección de incendios, SDI

Sistema de detección de incendios, SDI

El objetivo de los Sistemas de Detectores de Incendios es la provisión del aviso temprano de un principio de incendio. Comúnmente se componen de los siguientes elementos:

- iniciadores de alarmas: detectores de humo, detectores de temperatura, detectores de gases, detectores de llama, pulsadores de aviso manual, etc;

- panel de control con capacidad de notificación remota y registro de alarmas;

- elementos de sonorización y/o aviso visual: sirenas, parlantes y luces estroboscópicas

Sistemas de detección y aviso de incendios de reconocidas marcas, tales como: Notifier, Bosch, Apollo, System Sensor, Siemens-Cerberus, Fire-Lite y Vesta

El cableado estructurado consiste en el tendido de cable de par trenzado UTP / STP en el interior de un edificio con el propósito de implantar una red de área local. Suele tratarse de cable de par trenzado de cobre, para redes de tipo IEEE 802.3. No obstante, también puede tratarse de fibra óptica o cable coaxial (BNC)

Los conectores suelen ser de tipo RJ-45.

Para los conectores de fibra óptica, estos elementos se encargan de conectar las líneas de fibra a un elemento, ya puede ser un transmisor o un receptor. Los tipos de conectores disponibles son muy variados, entre los que podemos encontrar se hallan los siguientes:

- FC, que se usa en la transmisión de datos y en las telecomunicaciones.

- FDDI, se usa para redes de fibra óptica.

- LC y MT-Array que se utilizan en transmisiones de alta densidad de datos.

- SC y SC-Dúplex se utilizan para la transmisión de datos.

- ST o BFOC se usa en redes de edificios y en sistemas de seguridad.

Los cables de fibras ópticas, para adaptarse a los requerimientos de las instalaciones, necesitan ser empalmados con otros, ya sea porque la longitud de los rollos o bobinas de cables son menores a la longitud de las infraestructuras o porque para la distribución se utilizan cables con diferentes números de fibras.

También se realizan empalmes de las fibras que componen los cables en sus extremos con latiguillos (pigtails), para poder conectar estas fibras a los equipos transmisores y receptores que las utilizarán.

Las fibras ópticas son cables de vidrio flexible, fabricadas principalmente con sílice, por las que se transmiten señales luminosas, y están compuestas por: núcleo, revestimiento y protegidas por una cubierta de material plástico. Por el núcleo viaja la luz y el revestimiento tiene la misión de evitar que la luz abandone el núcleo.

Existen dos tipos principales de fibras ópticas: monomodo y multimodo. Las fibras monomodo tienen un núcleo de diámetro muy pequeño, (8 a 10 µm) y por él solamente puede viajar un modo de luz (rayo).

Las fibras multimodo tienen diámetros de núcleos superiores a 50 µm por lo que permiten la circulación de muchos modos de luz.

Las fibras monomodo permiten la transmisión de mayor cantidad de información por tener un ancho de banda superior al de las fibras multimodo.

Tipos de Empalmes

Existen dos tipos de empalmes: empalme mecánico y empalme por fusión. Un empalme mecánico consiste en alinear las fibras en un soporte que permita fijarlas mecánicamente o mediante pegamento.

Los empalmes mecánicos se utilizan principalmente en fibras multimodo aunque también se pueden utilizar con fibras monomodo, si éstas tienen bajos niveles de excentricidad, asumiendo que las pérdidas de inserción pueden ser mayores y las pérdidas de retorno menores que las de los empalmes por fusión.

Los empalmes por fusión se realizan fundiendo el material de las fibras mediante la aplicación de un arco eléctrico de alta tensión o cualquier otro sistema de calentamiento. Estos empalmes se utilizan con cualquier tipo de fibra: monomodo o multimodo, ofrecen menores pérdidas de inserción y altas pérdidas de retorno (menores reflexiones).

Existen máquinas para realizar estas actividades de empalme.

Un generador diesel es la combinación de un motor diesel con un generador eléctrico (a menudo un alternador ) para generar energía eléctrica .

Generadores diesel se utilizan en lugares sin conexión a la red eléctrica o posibles fallas del CPD , así como para aplicaciones más complejas. El tamaño de los generadores diesel es crítico para evitar baja carga o una escasez de energía.

Se suelen emplear un numero determinado de generadores (motores) diesel de tipo MTU. Estmos motores en sólo 15 segundos producen suficiente corriente para todos los sistemas incluido los de refrigeración. El estado constante de precalentamiento de los mismos asegura su rápida entrada en funcionamiento. Suelen estar dotados de un tanque de combustible diesel para abastecer el sistema en caso de fallo. Con el fin de hacer factible el sistema de forma autónoma, la normativa establecida por contrato puede garantizar el suministro de combistible en el menor plazo posible.

![]() Cuadro de conmutación de Emergencia

Cuadro de conmutación de Emergencia

Para el control de redes de emergencia. Incorporan una centralita electrónica encargada de medir y analizar la red eléctrica existente y gestionan en arranque y parada de un generador de emergencia en caso de fallo de la red existente. El funcionamiento se efectua de la siguiente forma. La centralita electrónica detecta la cantidad de energía o el fallo en la misma, inmediatamente gestiona el arranque del grupo de emergencia y lo acopla a la red destinada para ello, quedando la parte de la red de la compañia suministradora desconectada automaticamente por un contactor de potencia.

Unidad de distribución de alimentación (PDU) medida de rack.

La PDU medida es un dispositivo de distribución de alimentación independiente que proporciona monitoreo remoto de las cargas conectadas en tiempo real y ofrece alarmas definidas por el usuario para advertir acerca de sobrecargas potenciales de los circuitos. PDU administrada entrada y salida de alimentación, Visibilidad en tiempo real con indicador LED o LCD de advertencias de alarmas definidas por el usuario.

Además del LED de advertencia de sobrecarga estándar, se puede optar por una pantalla LCD iluminada de dos colores que muestra cálculos de alimentación de avanzada por fase y PDU.

Ejemplos de fabricantes Rack 19». Dell.

Un rack es un soporte metálico destinado a alojar equipamiento electrónico, informático y de comunicaciónes. Las medidas para la anchura están normalizadas para que sean compatibles con equipamiento de cualquier fabricante. También son llamados bastidores, cabinas, cabinets o armarios.

Externamente, los racks para montaje de servidores tienen una anchura estándar de 600 mm y un fondo de 600, 800, 900, 1000 y ahora incluso 1200mm. La anchura de 600 mm para racks de servidores coincide con el tamaño estándar de las losetas en los centros de datos. De esta manera es muy sencillo hacer distribuciones de espacios en centros de datos (CPD). Para el cableado de datos se utilizan también racks de 800 mm de ancho, cuando es necesario disponer de suficiente espacio lateral para el guiado de cables.

Los racks son útiles en un centro de proceso de datos, donde el espacio es escaso y se necesita alojar un gran número de dispositivos. Estos dispositivos suelen ser:

- Servidores cuya carcasa ha sido diseñada para adaptarse al bastidor. Existen servidores de 1, 2 y 4 unidades rack ; y servidores blade que permiten compactar más compartiendo fuentes de alimentación y cableado.

- Conmutadores y enrutadores de comunicaciones.

- Paneles de parcheo, que centralizan todo el cableado de la planta.

- Cortafuegos.

El equipamiento simplemente se desliza sobre un raíl horizontal y se fija con tornillos. También existen bandejas que permiten apoyar equipamiento no normalizado. Por ejemplo, un monitor o un teclado.

Las especificaciones de una rack estándar se encuentran bajo las normas equivalentes DIN 41494 parte 1 y 7, UNE-20539 parte 1 y parte 2 e IEC 297 parte 1 y 2, EIA 310-D y tienen que cumplir la normativa medioambiental RoHS.

Las columnas verticales miden 15,875 milímetros de ancho cada una formando un total de 31,75 milímetros (5/4 pulgadas). Están separadas por 450,85 milímetros (17 3/4 pulgadas) haciendo un total de 482,6 milímetros (exactamente 19 pulgadas). Cada columna tiene agujeros a intervalos regulares llamado unidad rack (U) agrupados de tres en tres. Verticalmente, los racks se dividen en regiones de 1,75 pulgadas de altura. En cada región hay tres pares de agujeros siguiendo un orden simétrico. Esta región es la que se denomina altura o «U».

La altura de los racks está normalizada y sus dimensiones externas de 200 mm en 200 mm. Siendo lo normal que existan desde 4U de altura hasta 46U de altura.

Es decir que un rack de 41U o 42U por ejemplo nunca puede superar los 2000 mm de altura externa. Con esto se consigue que en una sala los racks tengan dimensiones prácticamente similares aun siendo de diferentes fabricantes. Las alturas disponibles normalmente según normativa seria, 1000, 1200, 1400, 1600, 1800, 2000 y 2200 mm. La profundidad del bastidor no está normalizada, ya que así se otorga cierta flexibilidad al equipamiento. No obstante, suele ser de 600, 800, 900, 1000 incluso 1200 milímetros.

Existen también racks de pared que cumplen el formato 19″ y cuenta con fondos de 300, 400, 450, 500, 500 y 600 mm totales, siendo muy útiles para pequeñas instalaciones.

Un cubo es un conjunto de racks.

Con la solución CUBO se crea el contenedor definiendo pasillos térmicos, evitando la mezcla entre el aire frío y caliente, esto optimiza las funciones del CPD y aporta ahorros energéticos y operacionales. Además permite una organización de los racks. Existen una serie de fases para construir un cubo. Ejemplo: aqui.

Un servidor blade es un tipo de computadora para los centros de proceso de datos específicamente diseñada para aprovechar el espacio, reducir el consumo y simplificar su explotación.

Los servidores blade están diseñados para su montaje en bastidores al igual que otros servidores. La novedad estriba en que los primeros pueden compactarse en un espacio más pequeño gracias a sus principios de diseño.

Cada servidor blade es una delgada «tarjeta» que contiene únicamente microprocesador, memoria y buses. Es decir, no son directamente utilizables ya que no disponen de fuente de alimentación ni tarjetas de comunicaciones.

Estos elementos más voluminosos se desplazan a un chasis que se monta en el bastidor ocupando únicamente de cuatro (4U) a seis alturas (6U). Cada chasis puede albergar del orden de dieciséis «tarjetas» o servidores blade (según fabricante). El chasis lleva integrados los siguientes elementos, que son compartidos por todos los servidores:

- Fuente de alimentación: redundante y hot-plug.

- Ventiladores o elementos de refrigeración.

- Conmutador de red redundante con el cableado ya hecho, lo que simplifica su instalación.

- Interfaces de almacenamiento. En particular, es habitual el uso de redes SAN (Storage Area Network) de almacenamiento.

Además, estos servidores suelen incluir utilidades software para su despliegue automático. Por ejemplo, son capaces de arrancar desde una imagen del sistema operativo almacenada en disco. Es posible arrancar una u otra imagen según la hora del día o la carga de trabajo, etc.

Ventajas

- Son más baratos, ya que se requiere menos electrónica y fuentes de alimentación para el mismo número de servidores. También consumen menos energía.

- Ocupan menos espacio, debido a que es posible ubicar dieciséis (16) servidores donde habitualmente solo caben cuatro.

- Son más simples de operar, ya que eliminan la complejidad del cableado y se pueden gestionar remotamente.

- Son menos propensos a fallos ya que ningún servidor blade contiene elementos mecánicos.

- Son más versátiles, debido a que es posible añadir y quitar servidores sin detener el servicio, es decir, en caliente (como un disco duro).

Usos

Los servidores blade son aptos para los mismos usos que cualquier otro servidor. No obstante, son especialmente ventajosos para instalaciones de entornos de virtualización, en cluster y para web hosting.

Un switch es un dispositivo de propósito especial diseñado para resolver problemas de rendimiento en la red, debido a anchos de banda pequeños y embotellamientos. El switch puede agregar mayor ancho de banda, acelerar la salida de paquetes, reducir tiempo de espera y bajar el costo por puerto.

Opera en la capa 2 del modelo OSI y reenvía los paquetes en base a la dirección MAC.

El switch segmenta económicamente la red dentro de pequeños dominios de colisiones, obteniendo un alto porcentaje de ancho de banda para cada estación final. No están diseñados con el propósito principal de un control íntimo sobre la red o como la fuente última de seguridad, redundancia o manejo.

Al segmentar la red en pequeños dominios de colisión, reduce o casi elimina que cada estación compita por el medio, dando a cada una de ellas un ancho de banda comparativamente mayor.

Un router es un dispositivo de red que permite el enrutamiento de paquetes entre redes independientes. Este enrutamiento se realiza de acuerdo a un conjunto de reglas que forman la tabla de enrutamiento.

Es un dispositivo que opera en la capa 3 del modelo OSI. No debe ser confundido con un conmutador (capa 2).

Principio de funcionamiento

La función de enrutamiento trata las direcciones IP en función de sus direcciones de red definidas por la mascara de sub-red y las redirige de acuerdo al algoritmo de enrutamiento y su tabla asociada.

Estos protocolos de enrutamiento son implementados de acuerdo a la arquitectura de nuestra red y los enlaces de comunicación entre los sitios y entre las redes.

Los protocolos de enrutamiento

Los protocolos de enrutamiento permiten el intercambio de información dentro de un sistema autónomo. Tenemos los siguientes protocolos:

estado de enlace, se basa en la calidad y el rendimiento del medio de comunicación que los separa. De este modo cada router puede construir una tabla del estado de la red para utilizar la mejor ruta: OSPF

Vector distancia, cada router indica a los otros routers la distancia que los separa. Estos elaboran una cartografía de sus vecinos en la red: RIP

hybrido, combina aspecto de los dos anteriores, como EIGRP

Los protocolos comúnmente utilizados son:

Routing Information Protocol (RIP)

Open Shortest Path First (OSPF)

Enhanced Interior Gateway Routing Protocol (EIGRP)

Independientemente del tipo de maquinas de un datacenter, HP ha dado la campanada, pero además a lo grande, en el mercado de los servidores con su última criatura: el Moonshot. Estamos ante un servidor que promete un consumo de energía notablemente inferior y ocupando un espacio muy inferior a lo que estamos habituados. Se trata de «la segunda generación» de tecnología en servidores, según las propias palabras del fabricante, y está dirigido a su utilización «social, en la nube, dispositivos móviles y grandes cantidades de datos», según apuntan. El servidor ya apareció como prototipo el pasado verano, pero ahora se ha presentado de forma oficial.

Esta gama de servidores ha llegado al mercado durante la segunda mitad de 2013 y puede configurarse a la medida del cliente, ajustando las especificaciones según sus necesidades particulares, empleando componentes de varios proveedores (AMD, AppliedMicro, Calxeda, Intel y Texas Instruments, son los que han sido mencionado específicamente por HP). El fabricante se ha asomado con este producto a la tecnología del futuro en lo que toca a los servidores.

HP Moonshot nacen como un conjunto de servidores de potencia comedida pero que tienen en el factor energético a su gran aliado: según HP consumen un 89% menos de energía, algo fundamental en los grandes servidores; aunque hay más: también son más baratos y pequeños. Todo esto se realiza gracias a la nueva generación de procesadores de bajo consumo (el Atom S1260 tiene un TDP de 8.5 vatios) y buen rendimiento para ciertas tareas, algo genial para la paralelización tan importante en los grandes sistemas.

HP ha anunciado que el primer modelo será el denominado HP Moonshot 1500: un chasis que puede contener hasta 45 servidores (denominados ProLiant Moonshot Server), cada uno de ellos con el S1260, hasta 8 GB de memoria ECC, doble puerto Ethernet Gigabyte y un dispositivo de almacenamiento de 2.5 pulgadas. HP soporta sistemas Linux (Ubuntu, Red Hat o SUSE) esenciales en el mundo de la informática de sistemas. Si bien es cierto que Moonshot se postula como una opción muy interesante, lo mejor es el prometedor futuro que tiene esta nueva plataforma de HP: abrirán el mercado a otro tipo de procesadores (AMD o Texas Instruments entre otros muchos) e incluso tienen en mente ofrecer Moonshot basados en ARM, si bien por ahora no hay más detalles.

El hipervisor, también llamado monitor de máquina virtual (VMM), es el núcleo central de algunas de las tecnologías de virtualización de hardware más populares y eficaces, entre las cuales se encuentran las de Microsoft: Microsoft Virtual PC, Windows Virtual PC, Microsoft Windows Server e Hyper-V.

Los hipervisores son aplicaciones que presentan a los sistemas operativos virtualizados (sistemas invitados) una plataforma operativa virtual (hardware virtual), a la vez que ocultan a dicho sistema operativo virtualizado las características físicas reales del equipo sobre el que operan.

Los hipervisores también son los encargados de monitorizar la ejecución de los sistemas operativos invitados.

Con el uso de hipervisores es posible conseguir que múltiples sistemas operativos compitan por el acceso simultáneo a los recursos hardware de una máquina virtual de manera eficaz y sin conflictos.

Existen tres tipos principales de hipervisores en el mercado:

– Hipervisores de tipo 1 (También llamados nativos, unhosted o bare-metal): en ellos el hipervisor se ejecuta directamente sobre el hardware físico; el hipervisor se carga antes que ninguno de los sistemas operativos invitados, y todos los accesos directos a hardware son controlados por él.

Aunque esta es la aproximación clásica y más antigúa de la vitualización por hardware, actualmente las soluciones más potentes de la mayoría de fabricantes usa este enfoque. Es el caso de Microsoft Hyper-V, Citrix XEN Server y VMWare ESX-Server.

Nota: es muy frecuente que a los hipervisores en general se les aplique el término VMM (Monitores de máquina virtual), mientras que el término “Hypervisor” se reserva para los hipervisores de tipo 1.

-) Hipervisores de tipo 2 (también llamados hosted): en ellos el hipervisor se ejecuta en el contexto de un sistema operativo completo, que se carga antes que el hipervisor. Las máquinas virtuales se ejecutan en un tercer nivel, por encima del hipervisor.

Son típicos de escenarios de virtualización orientada a la ejecución multiplataforma de software, como en el caso de CLR de .NET o de las máquinas virtuales de Java.

-) Hipervisores híbridos: en este modelo tanto el sistema operativo anfitrión como el hipervisor interactúan directamente con el hardware físico.

Las máquinas virtuales se ejecutan en un tercer nivel con respecto al hardware, por encima del hipervisor,

pero también interactúan directamente con el sistema operativo anfitrión.

Es la aproximación usada en Microsoft Virtual PC, Microsoft Virtual Server, Parallels, VirtualBox, VMWare Server…

Nota: en algunas clasificaciones es posible que se incluyan los VMM de tipo híbrido dentro de los de tipo 2.

![]() Bandejas de discos #FC en cabinas

Bandejas de discos #FC en cabinas

Conjunto de discos destinados al almacenamiento masivo que están conectados a una red SAN. Difiere de las redes NAS y las más actuales SAS.

Estos discos se unen mediante FC (Fibre Channel)

Pretendo ampliar este tema …

Ver video.

Servidores con sistema iDRAC o gestión de la máquina remota.

Qué es iDRAC?

El iDRAC o Integrated Dell Remote Access Controller con Lifecycle Controller es un dispositivo integrado en los Servidores Dell PowerEdge que ayuda a los administradores de TI a administrar, supervisar, actualizar e implementar servidores Dell.

El Dell Remote Access Controller integrado (iDRAC) está diseñado para que los administradores de servidores sean más productivos y para mejorar la disponibilidad global de servidores de Dell. iDRAC alerta a los administradores de los problemas del servidor, les ayuda a realizar tareas de administración del servidor en remoto, y reduce la necesidad de tener acceso físico al servidor.

iDRAC7 con tecnología Lifecycle Controller es parte de una solución para gran cantidad de centro de datos que ayuda a mantener las aplicaciones críticas de negocio y cargas de trabajo disponibles en todo momento. La tecnología permite a los administradores implementar, monitorear, administrar, configurar, actualizar, solucionar y remediar los servidores Dell desde cualquier lugar, y sin el uso de agentes. Es independiente del sistema operativo.

Gamas de servidores 12G, enlace.

El Centro de Coordinación de redes IP europeas (Réseaux IP Européens Network Coordination Centre (RIPE NCC)) es el Registro Regional de Internet (RIR) para Europa, Oriente Medio y partes de Asia Central.

Un RIR supervisa la asignación y registro de los números de recursos de Internet (direcciones IPv4, direcciones IPv6 y números de Sistemas Autónomos) en una región específica.

RIPE NCC proporciona la coordinación administrativa de la infraestructura de Internet. Es una organización sin ánimo de lucro con más de 5000 miembros pertenecientes a los alrededor de 70 países perteneciente a su área de servicio.

Cualquier persona u organización puede convertirse en miembro de RIPE NCC. Sus miembros son básicamente Proveedores de Servicios de Internet (ISPs), organizaciones de telecomunicaciones, instituciones educativas, gobiernos, reguladores y grandes corporaciones.

RIPE NCC también proporciona soporte técnico y administrativo a Redes IP Europeas (Réseaux IP Européens (RIPE)), un foro abierto a todas las partes interesadas en el desarrollo técnico de Internet.

Una CDN (Content Delivery Network) es un conjunto de ubicaciones en el mundo, que redistribuyen localmente el contenido de los servidores de alojamiento y guardan en caché los archivos que no necesitan actualización permanente, según unas reglas personalizables. Este simple principio, sumado a las últimas innovaciones, la infraestructura y la red , le permitirá potenciar y optimizar en cada región todos sus sitios web internacionales.

Ventajas de una CDN

Una red de entrega de contenidos (CDN, content delivery network en inglés) es una red superpuesta de computadoras que contienen copias de datos, colocados en varios puntos de una red con el fin de maximizar el ancho de banda para el acceso a los datos de clientes por la red. Un cliente accede a una copia de la información cerca del cliente, en contraposición a todos los clientes que acceden al mismo servidor central, a fin de evitar embudos cerca de ese servidor.

Los tipos de contenido incluyen objetos web, objetos para descargar (archivos multimedia, software, documentos), aplicaciones, medios de comunicación en tiempo real y otros componentes de entrega de Internet(DNS, rutas y consultas de base de datos).

La CDN es imprescindible para dar servicio a usuarios de todo el mundo, ya sea para ofrecer la descarga de archivos o para implementar sitios y aplicaciones web.

Si usted o sus clientes quieren llegar a un público internacional, la CDN permite acelerar la carga de las páginas, mejorar los tiempos de respuesta y la experiencia de usuario, proteger los datos, mejorar el posicionamiento de los sitios web y reducir el consumo de ancho de banda en cada uno de los países.

El rendimiento de la inversión puede obtenerse muy pronto desde la difusión internacional de los contenidos.

El funcionamiento de la CDN en 4 etapas:

1) Los usuarios acceden a los contenidos desde cualquier lugar del mundo.

Las peticiones se envían a los servidores DNS. Gracias a la tecnología IP Anycast, la CDN redirige la petición al PoP CDN más cercano al usuario y con una latencia más baja. Imaginemos, por ejemplo, que el cliente esté en Fort Worth, en los Estados Unidos. En ese caso, sería redirigido al PoP situado en Dallas (es decir, a pocos kilómetros).

Uso de una content delivery network

2) Envío de los archivos al usuario y comunicación entre la CDN y los servidores de alojamiento.

Una vez enviada al usuario la petición de la CDN, pueden darse tres situaciones:

1. Los archivos solicitados aún no están disponibles en caché en ese PoP de la CDN, en cuyo caso la CDN los recupera del hosting y los reenvía desde el PoP al usuario.

2. Los archivos solicitados están en la caché del PoP (en función de las reglas configuradas), en cuyo caso se reenvían desde la caché del PoP, sin tener que recurrir a los servidores donde están alojados, liberándolos de una parte de la carga.

3. Los archivos o páginas solicitados son dinámicos o están excluidos por las reglas de caché configuradas. Entonces la CDN pide al servidor que envíe los contenidos solicitados al usuario.

Si el tiempo de vida (TTL, de «time lo live») de los archivos ha expirado, la CDN vuelve a pedirlos a los servidores.

Uso de una red de distribución de contenidosUso de una red de distribución de contenidosUso de una red de distribución de contenidos

3) Cuando acceda otro usuario, ¡el sitio será más rápido!

Cuando otro internauta solicite esa misma página, el punto CDN más cercano distribuirá el contenido estático directamente de su caché, sin enviar ninguna petición al hosting. Usted puede configurar el tiempo de vida de sus archivos. El punto CDN comprobará esa información antes de distribuir los archivos; si ha expirado, volverá a solicitarlos al alojamiento.

Funcionamiento de una red de distribución de contenidos

4) ¿Y sin CDN?

Sin CDN, cada petición de un usuario situado en Fort Worth deberá, en cada conexión al sitio web, recorrer un trayecto mucho más largo (tan largo como la distancia que le separa del lugar de alojamiento del sitio web). Si el sitio web está alojado en Francia, el tiempo de carga será necesariamente mayor. Así pues, la ventaja del CDN es que reduce el tiempo de latencia, acercando los sitios web y aplicaciones a sus usuarios, y reduciendo la carga de los servidores y del ancho de banda que los conecta a la red

Un punto neutro (en inglés IXP, Internet Exchange Point, también llamados NAP (Network Access Point, Punto de Acceso a la Red)) es una infraestructura física a través de la cual los proveedores de servicios de Internet (PSI) intercambian el tráfico de Internet entre sus redes. Esta instalación reduce la porción del tráfico de un PSI que debe ser entregado hacia la red, lo que reduce el costo promedio por bit de la entrega de su servicio. Además, el aumento del número de rutas «aprendidas» a través del punto neutro mejora la eficiencia de enrutamiento y la tolerancia a fallos.

El propósito principal de un punto neutro es permitir que las redes se interconecten directamente, a través de la infraestructura, en lugar de hacerlo a través de una o más redes de terceros. Las ventajas de la interconexión directa son numerosas, pero las razones principales son el coste, la latencia y el ancho de banda. El tráfico que pasa a través de la infraestructura no suele ser facturado por cualquiera de las partes, a diferencia del tráfico hacia el proveedor de conectividad de un PSI. La interconexión directa, a menudo situada en la misma ciudad que ambas redes, evita la necesidad de que los datos viajen a otras ciudades (potencialmente hacia otros continentes) para pasar de una red a otra, lo que reduce la latencia. La tercera ventaja, la velocidad, es más notable en las áreas que tienen poco desarrolladas las conexiones de larga distancia.

Los PSI en estas regiones podrían tener que pagar entre 10 o 100 veces más por el transporte de datos que los PSI en América del Norte, Europa o Japón. Por lo tanto, estos PSI tienen normalmente conexiones más lenta y limitadas hacia el resto de la Internet. Sin embargo, una conexión a un punto neutro local les puede permitir el transferir datos sin límite, y sin costo, mejorando enormemente el ancho de banda entre los clientes de los dos PSI adyacentes.

La técnica y la logística de negocios de intercambio de tráfico entre los PSI se rige por los acuerdos de interconexión mutua. En virtud de dichos acuerdos, el tráfico a menudo se intercambia sin compensación. Cuando un punto neutro incurre en costos de operación, por lo general éstos son compartidos entre todos sus participantes. En los intercambios más caros, los participantes pagan una cuota mensual o anual, por lo general determinada por la velocidad del puerto o puertos que están usando, o menos comúnmente por el volumen de tráfico efectuado a través de la infraestructura del punto neutro. Las cuotas basadas en el volumen de tráfico no son populares porque no ofrecen incentivos al crecimiento del punto neutro. Algunos puntos neutros cobran una tarifa de configuración para compensar los gastos de puerto del puerto del conmutador y cualesquiera adaptadores de medios, tales como convertidores de interfaces gigabit, transceptores enchufables, transceptores XFP, etc.

Actualmente en España existen los puntos neutros de Euskonix, Catnix y ESPANIX, siendo este último el más importante en cuanto a cantidad de tráfico en España, y uno de los más altos de Europa, pasando de los 180Gb por segundo.

El peering es la interconexión voluntaria de redes de Internet administrativamente independientes con el fin de intercambiar tráfico entre los clientes de cada red.

El peering implica la interconexión voluntaria entre dos redes en internet administrativamente independientes, con el propósito de intercambiar tráfico entre usuarios de cada una de las redes. La definición estricta significa «libre acuerdo» o «el remitente se hace cargo», esto es, ninguna de las partes paga a la otra por el intercambio de tráfico, sino que cada una deriva el crédito de sus propios clientes. La comercialización y las presiones comerciales han llevado al uso rutinario de esta palabra toda vez que hay un cierto acuerdo implícito, aunque no se trata de su sentido técnico exacto. La frase “peering de libre acuerdo” se utiliza a veces para reflejar esta realidad y para describir sin lugar a dudas que se trata de un intercambio de información sin costo. El peering requiere la interconexión física de las redes, un intercambio de la información de encaminamiento con el protocolo de encaminamiento del Border Gateway Protocol (BGP) y, a menudo, va acompañado por acuerdos que implican diversa formalidad que varía, del simple “handshake” a conexiones más complejas.

El multihoming de sitio se define como la conexión de un host o sitio a más de un ISP a la vez, y es hoy por hoy un componente esencial para muchos sitios conectados a Internet.

El caso típico de multihoming se ilustra en la Figura 1. El sitio X se conecta a dos ISPs que le dan acceso a Internet. Para ello se utilizan cuatro routers, los que están en el sitio se denominan routers de salida, mientras que los que están en cada uno de los ISPs son los routers de entrada o routers de acceso.

JumpBox es una web que ofrece distribuciones virtuales listas para ejecutar con un determinado servicio ya en marcha. Soluciones para foros, CMS, wikis, blogs, portales, CRM,… Ya los tenemos montados, los bajamos y listos para usar en VMWARE. Para probar servicios, sin andar montándolos, es una solución maravillosa.

En informática, una copia instantánea de volumen o Snapshot es una instantánea del estado de un sistema en un momento determinado. El término fue acuñado como una analogía a la de la fotografía. Puede referirse a una copia real del estado de un sistema o de una capacidad que ofrecen los sistemas de copia de seguridad.

Un switch KVM (Keyboard-Video-Mouse) es un dispositivo de computación que permite el control de distintos equipos informáticos con un solo monitor, un único teclado y un único ratón. Este dispositivo nos permite dotar al puesto de trabajo de tan sólo una consola para manejar al mismo tiempo varios PC o servidores, conmutando de uno a otro según necesidad. Hay múltiples tipos, permitiendo la conmutación también de audio, micrófono y dispositivos periféricos mediante puertos USB. Existen también modelos con gestión de los PC o servidores a través de conexiones TCP/IP, por lo que podríamos manejar nuestros equipos a través de internet como si estuviéramos sentados frente a ellos. Dentro de la categoría de consolas con uso de protocolo TCP/IP, las hay con conexión serie (usada en equipos de comunicaciones y Unix) y de conexión gráfica (usada para Microsoft Windows y GNU/Linux).

NetApp, Inc. , anteriormente Network Appliance, Inc. , es un equipo de almacenamiento y gestión de datos de la compañía con sede en Sunnyvale, California . Es un miembro del índice NASDAQ-100 . Se clasificó en la lista Fortune 500 , por primera vez en 2012.

La línea de servidores de archivos NetApp ha servido como insignia de la compañía de productos desde el principio. Un archivador es un tipo de dispositivo de almacenamiento en disco que posee y controla un sistema de ficheros , y presenta los archivos y directorios a los hosts en la red.Este esquema se llama a veces el almacenamiento de archivos , en comparación con el almacenamiento en bloque que los principales proveedores de almacenamiento como EMC Corporation y Hitachi Data Systems proporcionan tradicionalmente.

Archivadores de NetApp utilizados inicialmente NFS y CIFS protocolos basados en estándares de redes de área local (LAN), mientras que la consolidación del almacenamiento bloque deseado redes de área de almacenamiento (SAN) implementados con el canal de fibra de protocolo (FC).En 2002, en un intento de aumentar la cuota de mercado, NetApp añade el acceso al almacenamiento de bloques también. Hoy en día, los sistemas de NetApp soportan a través del protocolo FC, el iSCSI protocolo y el emergente de canal de fibra sobre Ethernet (FCoE) de protocolo.

Un Sistema Autónomo (en inglés, Autonomous System: AS) se define como “un grupo de redes IP que poseen una política de rutas propia e independiente”. Esta definición hace referencia a la característica fundamental de un Sistema Autónomo: realiza su propia gestión del tráfico que fluye entre él y los restantes Sistemas Autónomos que forman Internet. Un número de AS o ASN se asigna a cada AS, el que lo identifica de manera única a sus redes dentro de Internet.

Los Sistemas Autónomos se comunican entre sí mediante routers, los que intercambian información para tener actualizadas sus tablas de ruteo mediante el protocolo BGP e intercambian el tráfico de Internet que va de una red a la otra. A su vez cada Sistema Autónomo es como una Internet en pequeño, ya que su rol se llevaba a cabo por una sola entidad, típicamente un Proveedor de Servicio de Internet (ISP) o una gran organización con conexiones independientes a múltiples redes, las cuales se apegaban a una sola y clara política de definición de trayectorias. El RFC 1771 describía la definición original (obsoleta) del Protocolo BGP (Border Gateway Protocol). La nueva definición RFC 1930 fue necesaria debido a que múltiples organizaciones podían utilizar BGP con números de AS privados con un ISP que conecta a todas estas organizaciones a Internet. Aún considerando que el ISP podía soportar múltiples sistemas autónomos, Internet solo considera la política de definición de trayectorias establecida por el ISP. Por lo tanto, el ISP debería contar con un ASN registrado.

Hasta el año 2007 los números de sistemas autónomos estaban definidos por un número entero de 16 bits lo que permitía un número máximo de 65536 asignaciones de sistemas autónomos. Debido a la demanda, se hizo necesario aumentar la posibilidad La RFC 4893 introduce los sistemas autónomos de 32-bits, que IANA ha comenzado a asignar. Estos números de 32 bits se escriben como un par de enteros en el formato x.y, donde x e y son números de 16 bits. La representación textual de Números de sistemas autónomos está definido en la RFC 5396.

Asignación

Los números de Sistemas Autónomos son asignados en bloques por la Internet Assigned Numbers Authority (IANA) a Registros Regionales de Internet (RIRs). Los RIR apropiados en este caso LACNIC asignan los números de sistemas autónomos a las entidades que tienen bloques de direcciones asignadas por LACNIC. Las entidades que quieren recibir un número de sistema autónomo deben llenar un formulario ante LACNIC y ser aprobados antes que se le asigne el número de sistema autónomo.

Los números de sistemas autónomos asignados por IANA pueden se encontrados en el sitio web de IANA.

RIP son las siglas de Routing Information Protocol (Protocolo de Información de Enrutamiento). Es un protocolo de puerta de enlace interna o IGP (Interior Gateway Protocol) utilizado por los routers (encaminadores), aunque también pueden actuar en equipos, para intercambiar información acerca de redes IP. Es un protocolo de Vector de distancias ya que mide el número de «saltos» como métrica hasta alcanzar la red de destino. El límite máximo de saltos en RIP es de 15, 16 se considera una ruta inalcanzable o no deseable.

La fibra óptica es un medio de transmisión empleado habitualmente en redes de datos; un hilo muy fino de material transparente, vidrio o materiales plásticos, por el que se envían pulsos de luz que representan los datos a transmitir. El haz de luz queda completamente confinado y se propaga por el interior de la fibra con un ángulo de reflexión por encima del ángulo límite de reflexión total, en función de la ley de Snell. La fuente de luz puede ser láser o un LED.

Las fibras se utilizan ampliamente en telecomunicaciones, ya que permiten enviar gran cantidad de datos a una gran distancia, con velocidades similares a las de radio y superiores a las de cable convencional. Son el medio de transmisión por excelencia al ser inmune a las interferencias electromagnéticas, también se utilizan para redes locales, en donde se necesite aprovechar las ventajas de la fibra óptica sobre otros medios de transmisión.

Building Management System, está compuesto por un software y un hardware implementado en los equipos relacionados con la seguridad de la edificación y los relacionados con los servicios de la edificación (También llamados equipos electromecánicos).

Para data center más grandes, el sistema de gestión de edificios (BMS) permitirá un seguimiento constante y centralizado de la instalación (Facilities), incluyendo la temperatura, humedad, energía y refrigeración. Control de: Detección de incendios, Extinción de incendios, Control de Acceso, Control de Intrusión, Circuito Cerrado de Televisión (CCTV),Control de Activos.

(Power Usage Effectiveness): Creado por los miembros de The Green Grid, PUE es una medida utilizada para determinar la eficiencia de energía de un data center. El PUE del data center se calculará dividiendo la cantidad de potencia entrante entre la potencia que emplea la infraestructura de TI. Se expresa como un ratio, la eficiencia mejora al aproximarse a 1. El PUE en el data center por lo general va desde alrededor de 1,3 (bueno) y 3,0 (malo), con un promedio de 2,5 (no tan bueno).

(Data Center Infrastructure Efficiency): Creado por los miembros de The Green Grid, DCiE es otra medida utilizada para determinar la eficiencia energética de un data center, y es el recíproco del PUE. Se expresa como un porcentaje y se calcula dividiendo la potencia de los equipos de TI por la potencia total de la instalación. Mejora la eficiencia como la DCiE al acercarse al 100%. El DCiE de un data center suele oscilar entre el 33% (malo) a 77% (bueno), con un DCiE promedio de 40% (no tan bueno).

Desarrollado por los EE.UU. Green Building Council (USGBC), LEED es un sistema internacionalmente reconocido de certificación de edificios verdes. Proporciona la verificación por terceros de que un edificio fue diseñado y construido utilizando las estrategias destinadas a mejorar el rendimiento en todas las métricas: el ahorro de energía, la eficiencia del agua, la reducción de las emisiones de CO2, la calidad del ambiente interior, la administración de los recursos y la sensibilidad de su impacto sobre el medio ambiente en general. Para más información sobre LEED, vaya a www.usgbc.org.

La idea de un data center en un contenedor es que toda la energía, la refrigeración, el espacio y la conectividad se pueden aprovisionar de forma incremental a través de bloques de construcción o contenedores para transporte de tamaño estándar. Estos recipientes se pueden colocar fuera de su lugar de trabajo para ampliar la capacidad del data center o se puede implementar en un entorno tipo de almacén. Un beneficio de la solución de contenedores par data center es que permiten la rápida implementación y se integran y configuran para soportar muy altas densidades de potencia. Los contenedores han sido adoptados para su uso en servicios de tipo nube de Google y Microsoft. Las desventajas potenciales de los contenedores son varios: Son caros, tienden a ser homogéneos (diseñado para las marcas y modelos específicos de los sistemas) y están destinados a un funcionamiento autónomo (el recipiente debe permanecer sellado para operar dentro de las especificaciones).

![]() CRAC (Computer Room Air Conditioner)

CRAC (Computer Room Air Conditioner)

Es un aparato de aire acondicionado especializado para aplicaciones de data center que puede incrementar la humedad del aire para mantener el nivel de humedad adecuado requerido por los sistemas electrónicos.

![]() Enfriamiento basado en Chiller:

Enfriamiento basado en Chiller:

Es un tipo de refrigeración en la cual se utiliza agua fría para disipar el calor en la unidad CRAC (en lugar de glicol o refrigerante). El intercambiador de calor en un sistema de refrigeración basado puede ser aire o agua helada. El Sistema basado en Chiller cuenta con unidades CRAC con capacidad de enfriamiento mayor que los sistemas basados en DX. Además de la eliminación de la limitación de DX de unos – 4 ° C. de propagación entre la salida y entrada, el sistema de enfriamiento se puede ajustar de forma dinámica basándose en la carga.

Al igual que la chimenea en casa aprovecha las diferencias de presión de aire para direccionar la salida. Esto ha dado lugar a un diseño común con el aire frío que se alimenta por debajo de un piso elevado, luego se envía al data center y se dirige como aire caliente en la parte superior a través de la chimenea. Este diseño crea una circulación muy eficiente de aire fresco y reduce al mínimo la mezcla de aire.

Este es el uso de un motor (típicamente diesel o gas natural basado) para generar electricidad y calor útil simultáneamente. El calor emitido por el motor en un data center puede ser utilizado por una “máquina de absorción” (un tipo de enfriadora que convierte la energía de calor en refrigeración) proporcionar beneficios de enfriamiento, además de energía eléctrica. Además, el exceso de electricidad generada por el sistema puede ser vendido de nuevo a la red eléctrica para cubrir los costes. En la práctica, el retorno de la inversión efectiva de la cogeneración depende en gran medida el diferencial entre el coste de la electricidad y el combustible. La alternativa de cogeneración también contribuirá al aumento sustancial de las emisiones de CO2 de las instalaciones. Esto va en contra de la tendencia hacia soluciones ecológicas.

Un Green Data Center es el que puede operar con máxima eficiencia energética y mínimo impacto ambiental. Esto incluye los equipos mecánicos, de iluminación, eléctricos y de TI (servidores, almacenamiento, red, etc.) Dentro de las empresas, el enfoque de los green data center se debe principalmente a un deseo de reducir los enormes costos de la electricidad asociados con la operación de un data center. Es decir, ser verde es reconocido como una manera de reducir significativamente los gastos operativos de la infraestructura de TI.

El interés en los green data centers también está siendo impulsado por el gobierno federal de los EE.UU. En el año 2006, el Congreso aprobó la Ley Pública 109-431 pidiendo a la EPA: “analizar el rápido crecimiento y el consumo de energía de los data center por el Gobierno Federal y la empresa privada”.

En respuesta, la EPA desarrolló un informe exhaustivo analizando las tendencias actuales en el uso de la energía y los costos de la energía de los data center y servidores en los EE.UU. y subrayó las oportunidades existentes y emergentes para la mejora de la eficiencia energética. También se formularon recomendaciones para aprovechar estas oportunidades de eficiencia energética en general en todo el país a través del uso de programas de información y basados en incentivos.

De acuerdo con el informe de la EPA, los dos mayores consumidores de electricidad en el data center son los siguientes:

• Infraestructura de soporte- el 50% del total

• General de servidores – 34% del total

Desde entonces, se han hecho importantes avances para mejorar la eficiencia de los servidores. Alta densidad y servidores blade de almacenamiento se ofrece ahora mucho más capacidad de cómputo por vatio de energía. La virtualización de servidores está permitiendo a las organizaciones a reducir el número total de servidores que soportan, y la introducción de los servidores de EnergyStar se han combinado para ofrecer muchas opciones, tanto para los sectores público y privado para reducir el 34% de la electricidad que se gasta en los servidores en general.

Por supuesto, la mayor oportunidad para ahorros adicionales es en la infraestructura de soporte de la instalación del data center en sí. Según la EPA, la mayoría de los data centers consumen del 100% al 300% de energía adicional para los sistemas de soporte del que se están utilizando para su operaciones centrales de TI. A través de una combinación de las mejores prácticas y la migración a mejoras en las instalaciones con rápido retorno de la inversión (como la humidificación ultrasónica y control del flujo de aire), esta sobrecarga se puede reducir a un 30% de la carga de TI.

Un balanceador de carga fundamentalmente es un dispositivo de hardware o software que se pone al frente de un conjunto de servidores que atienden una aplicación y, tal como su nombre lo indica, asigna o balancea las solicitudes que llegan de los clientes a los servidores usando algún algoritmo (desde un simple Round Robin hasta algoritmos más sofisticados).

Entre los fabricantes más populares de balanceadores por hardware se tiene a F5 y a Citrix.

![]() Paneles de control de administracion de servidores.

Paneles de control de administracion de servidores.

El panel de control de un servidor web es un software que provee una interfaz gráfica para la gestión de usuarios y la administración de los servicios del servidor.

Generalmente son en sistemas operativos tipo unix, tal como GNU/Linux y BSD, sin embargo también existen en otras plataformas como por ejemplo Windows Server.

Algunas de las funciones que contienen los paneles de control son:

- Estadísticas de visitas.

- Detalles sobre la cuota de ancho de banda utilizada.

- Administración de archivos y directorios.

- Configuración de cuentas de correo electrónico.

- Administración de bases de datos.

- Administración de cuentas de usuarios de servidores FTP.

- Acceso a los archivos de registros del servidor.

- Manejo de subdominios.

Destacan Plesk, Cpanel, etc …, ver artículo publicado anteriormente.

http://www.palentino.es/blog/paneles-de-control-de-administracion-de-servidores/

Son salas fundamentales para el suministro de corriente sin interrupciones. En caso de que se produzcan cortes en el consumo eléctrico, todos los ordenadores se alimentarán a través de equipos SAI que poseen baterias con determinadas potencias KVA que permiten un tiempo de aguante determinado por su capacidad. Muchas de estas baterias son acumuladores de gel que no necesitan mantenimiento. En caso de cortes eléctricos de mayor duración, entrarán en funcionamiento los motores diesel ya comentados en este post.

![]() Certificaciones o acreditaciones

Certificaciones o acreditaciones

Muchos Datacenters cuentan con acreditaciones de diferentes marcas o fabricantes de productos. Garantizan calidad y experiencia. Ejemplos son HP, Microsoft, Parallels, Verisign, Vmware, Thawte, Aenor, SGS, etc.

Una sala de control es una lugar en el cual es necesario tener un control de todos los equipos con los cuales se trabaja. Cualquier entorno de trabajo necesita ser lo suficientemente flexible para soportar una carga de trabajo constante y a su vez estar preparado para alguna necesidad de cambios tecnológicos o estructurales en el futuro.

Las soluciones para Salas de Control son escalables, flexibles y de alto rendimiento lo que permite usar y renovar el espacio adaptando cada solución a los constantes cambios.

Centreon es un software de monitoreo de red adaptado a las necesidades de un ISP. Combina la flexibilidad de código abierto con las características esenciales de supervisión.

Se utiliza en todo el mundo, Centreon ahora cuenta con más de 25.000 usuarios.

Centreon es un software libre y de código abierto que le permite controlar todas las infraestructuras y aplicaciones de su sistema de información. Componentes técnicos y funcionales Centreon que ofrecen todas las características esenciales de un sistema de monitoreo completo y profesional. Responde a las necesidades de los más exigentes Departamentos de Sistemas de Información (ISD) mientras que proporciona la flexibilidad vinculada al Open Source.

![]() Licenciamiento Microsoft SPLA.

Licenciamiento Microsoft SPLA.

Un licenciamiento a la medida de sus necesidades. Programa de licenciamiento mensual que permite arrendar licencias de Microsoft, para brindar servicios de software y aplicaciones hosted a sus clientes.

Microsoft Services Provider License Agreement (SPLA) se trata de un programa de licencias que permite a los proveedores de servicios e ISVs, la posibilidad de alquilar licencias mensualmente para prestar servicios y aplicaciones de hosting a clientes finales, sin la necesidad de realizar una inversión de capital inicial y evitando los riesgos correspondientes.

Posibilita que los proveedores de servicios puedan ofrecer alojamiento, externalización y otros servicios, evitando costos iniciales, planificando el presupuesto de licencias y pagando sólo por lo que se usa.

http://www.licenciasonline.com/ar/es/cloud/microsoft-spla

![]() Acuerdo de nivel de servicio o Service Level Agreement, también conocido por las siglas ANS o SLA

Acuerdo de nivel de servicio o Service Level Agreement, también conocido por las siglas ANS o SLA

Un ANS es un acuerdo negociado entre dos partes donde una de ellas es el cliente y la otra un proveedor de servicios. Estos acuerdos pueden estar vinculados legalmente, o ser un contrato informal (relaciones inter-departamentales). Los contratos entre los proveedores de servicios y una tercera parte son habitualmente y de forma incorrecta, llamadas también ANS, aunque el nivel de servicio ya ha sido definido por el cliente inicial y por lo tanto el acuerdo entre terceras partes no es más que un contrato.

Los ANS definen un punto de entendimiento común sobre servicios, prioridades, responsabilidades y garantías. Cada área de servicio debe tener un ANS definido, que comprenda los niveles de disponibilidad, servicio, rendimiento u otros atributos del servicio, como la facturación. El nivel del servicio también puede ser especificado como objetivo y mínimo, de forma que los usuarios puedan saber que esperar (mínimo), mientras se ofrece un objetivo que muestra el nivel de rendimiento. En algunos contratos pueden figurar penalizaciones en caso de incumplimiento de los ANS. Es importante remarcar que los acuerdos hacen referencia a los servicios que recibe el usuario, pero no como el proveedor ofrece ese servicio.

Los ANS se han utilizado desde finales de los años 80 por parte de operadores de telecomunicaciones como parte de sus contratos con clientes empresariales. Esta práctica se ha extendido hasta tal punto que actualmente es habitual que un usuario firme un contrato con un proveedor de servicios que incluya una serie de ANS para prácticamente todos los mercados.

Los departamentos de grandes corporaciones han adoptado también el sistema de acuerdos de nivel de servicio respecto a los clientes internos, departamentos de la misma organización ya que mediante este sistema se logra mejorar la calidad del servicio.

Los ANS están, por su naturaleza, basados en los resultados del servicio recibido por el usuario como elemento del acuerdo. Las organizaciones también pueden definir y especificar el sistema por el que el servicio debe ser cumplido mediante una especificación (especificación del nivel de servicio). Este tipo de acuerdo recibe el nombre de input SLA, aunque este tipo de acuerdo ha quedado obsoleto ya que las organizaciones permiten a los proveedores seleccionar el método de cumplimiento de los acuerdos.

FIN. Espero vuestras aportaciones.

Gracias por el artículo, me ha parecido súper interesante. En cuanto a la climatización de los data center me han hablado muy bien de la empresa Cliatec. http://www.cliatec.com/

Buenaass..!! El artículo me parece super completo. enhorabuena por al información que nos das. Un saludo.