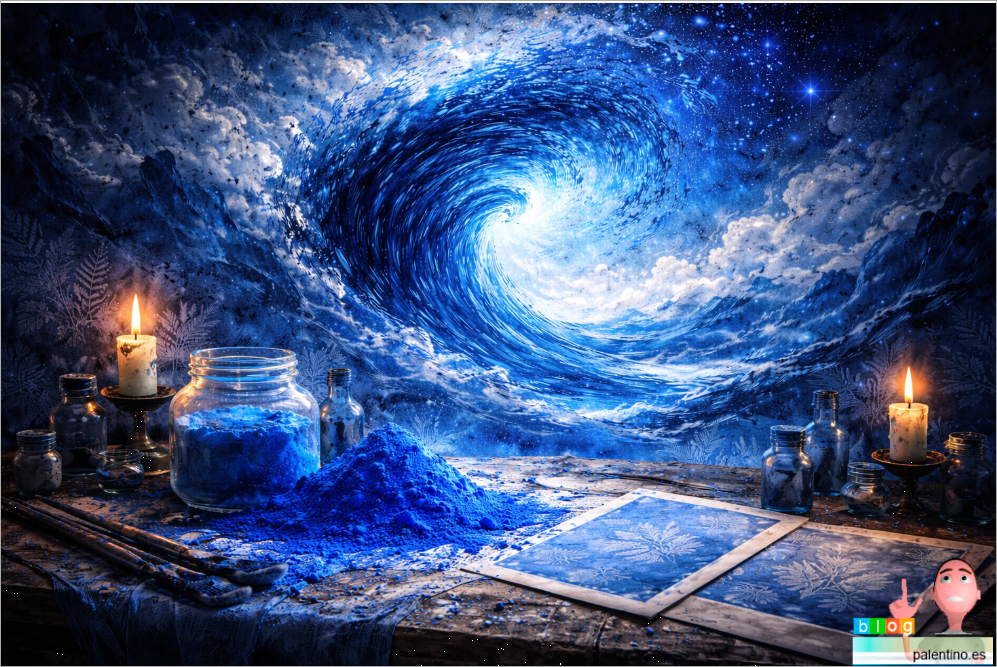

El Azul de Prusia no es solo un pigmento bonito. Es historia, química oscura, accidente científico y emoción humana concentrados en un solo color.

🧪 Un descubrimiento accidental… y turbio

En 1704, en Berlín, el químico Johann Jacob Diesbach intentaba fabricar un pigmento rojo. Para ello usó potasa contaminada, sin saberlo, con residuos orgánicos animales. Aquella potasa se obtenía al calcinar restos como sangre, huesos o cuero.

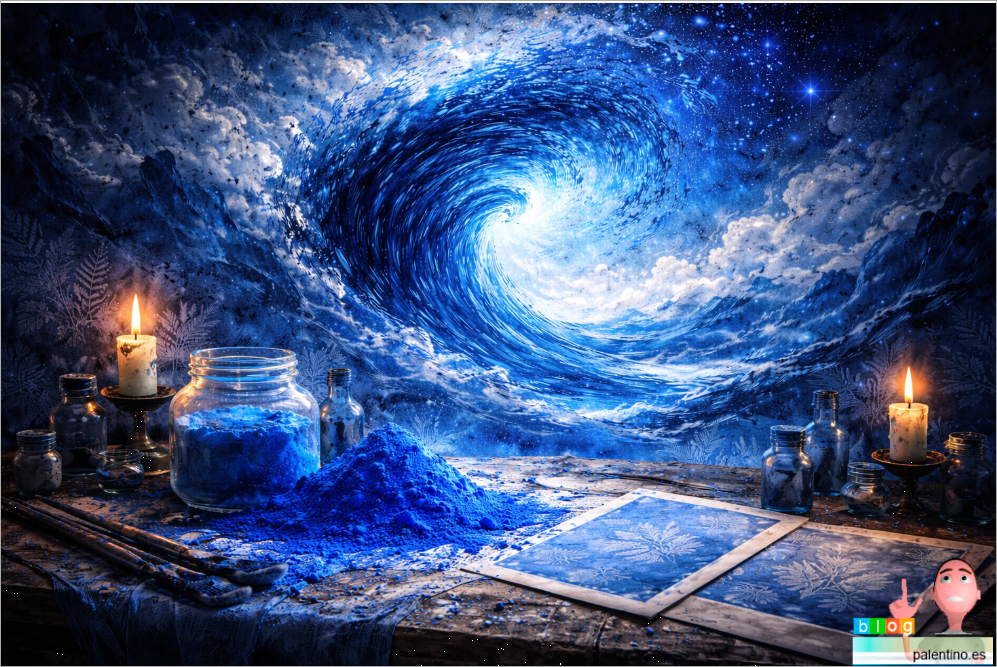

El resultado fue inesperado: un azul profundo, denso y casi hipnótico. Había nacido el primer pigmento sintético moderno. Así nace la cianotipia (cyanotype).

☠️ La conexión con el cianuro

Aquí viene lo inquietante: el Azul de Prusia es ferrocianuro férrico. Sí, contiene cianuro, pero atrapado en una estructura química tan estable que no libera veneno en condiciones normales.

La paradoja es brutal:

👉 un pigmento relacionado con el cianuro se usa hoy como antídoto médico para intoxicaciones por cesio y talio.

Belleza y veneno, juntos.

🩸 ¿De verdad hubo sangre?

No es una leyenda romántica. En el siglo XVIII, muchos reactivos químicos se fabricaban con restos animales. El azul que hoy asociamos al arte nació, literalmente, de materia orgánica en descomposición.

Por eso durante décadas fue visto como un color “impuro”, casi alquímico.

🎨 El azul que cambió el arte

Antes de él, el azul era carísimo (lapislázuli de Afganistán). El Azul de Prusia era barato, intenso y reproducible, lo que permitió que el azul inundara grabados, lienzos y libros.

- Katsushika Hokusai lo convirtió en océano y fuerza natural en La gran ola.

- Vincent van Gogh lo usó para noches agitadas, cielos mentales, estados internos.

- Pablo Picasso lo transformó en lenguaje del dolor durante su Periodo Azul: pobreza, soledad, tristeza, silencio.

😔 El color de la tristeza

Desde el siglo XIX, este azul quedó ligado a la melancolía. No es casual: es un azul frío, profundo, casi infinito, que parece absorber la luz.

Psicológicamente se asocia a:

- introspección

- duelo

- soledad

- silencio emocional

No es un azul alegre. Es un azul que piensa.

🧠 Más curiosidades fascinantes

- Se usó para copias técnicas (blueprints).

- Ha sido empleado en baterías, sensores y arte digital moderno.

- En altas concentraciones puede oscurecerse con el tiempo, como si envejeciera con la obra.

- Es uno de los pocos pigmentos que une arte, medicina, guerra, química y emoción.

- La cianotipia fue usada también por botánicos y artistas para crear: siluetas de plantas, formas casi espectrales,imágenes que parecen fantasmas de luz

Un arte donde la ausencia de luz dibuja.

🔵 En resumen

El Azul de Prusia no es solo un color:

es un accidente,

nace de la sangre,

convive con el veneno,

cura en la medicina,

y expresa como pocos la tristeza humana.

Un azul hermoso… y profundamente inquietante. 💙